作者:VRPinea

该文章首发于2018年7月4日

大家知道,目前,人脸识别系统存在着争议。例如亚马逊此前因向执法机构出售人脸识别技术一事,登上了头条,遭到万人上书抨击。此外,国内外都有学校正在使用人脸识别摄像头,来监控学生。

社会各界对此做法的评价,亦是褒贬不一。而“战斗民族”俄罗斯的最大科技公司Yandex的技术总监Grigory Bakunov,甚至与黑客合作开发了反人脸识别涂装。另外,也有研究表明,某些人脸识别软件可能存在种族偏见的问题。

人脸识别褒贬不一,多伦多大学研发反人脸识别系统

据了解,考虑到人们对人工智能监视系统的担忧,多伦多的研究人员开发出了一个防御系统。Parham Aarabi和研究生Avishek Bose创建了一种算法,通过对图像进行光转换,可以动态地破坏人脸识别系统。

Aarabi在一份声明中表示:“随着人脸识别技术的不断发展,个人隐私是一个相当重要的问题。”而这种算法,正是可用于反人脸识别系统,有益于防御愈变愈强的人脸识别能力。

事实上,反人脸识别产品和软件,并不是什么新鲜事。例如,在2016年11月的一项研究中,美国卡耐基梅隆大学的研究人员设计出了,能够成功骗过面部识别系统的眼镜。而2017年11月,麻省理工学院和九州大学的专家们,又用算法生成了“对抗性”图像,成功骗过了谷歌的图像分类AI,导致其将3D打印的乌龟玩具错认成了步枪。

根据Bose和Aarabi的说法,这是最早使用AI的解决方案之一。

工作原理:采用基于数据集的AI对抗训练

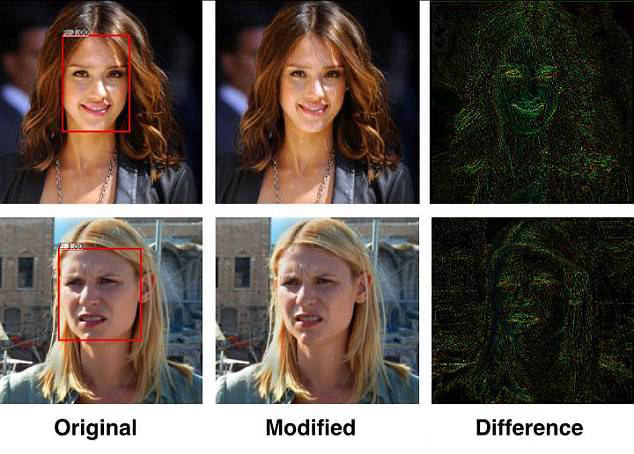

而多伦多研究人员的算法,则是在600张人脸的数据集上进行训练的,并提供一个可应用于任何图片的实时滤镜。由于它针对图像中高度特定的、单个像素,因此几乎是肉眼所看不到的。

这两位研究人员采用了AI对抗训练,由两个神经网络组成。一个神经网络相当于产生数据输出的“生成器”,另一个相当于检测生成器所制造的假数据的“鉴别器”。也就是说,Aarabi和Bose的系统,使用生成器来获取信息、识别面部;而鉴别器则用来干扰面部识别。

据悉,他们的研究报告,将在2018年IEEE国际多媒体信号处理研讨会上,进行发表。Bose和Aarabi声称,他们的算法,将人脸识别系统中检测到的人脸比例降低到0.5%。他们希望在应用程序或网站上提供这种神经网络。

“十年前,这些算法必须是人为定义的,而现在只要提供下训练数据,神经网络就可以自己学习。”Aarabi说,“最终他们可以做一些非常了不起的事情。这是一个非常有趣的时刻,这是一个巨大的潜力。”

反思后的反思,反人脸识别系统就一定安全么?

小编看到,多伦多大学研究人员,开发AI反人脸识别系统的出发点是好的——考虑到人们对人工智能监视系统的担忧。但是这无疑又不得不引发出另一种担忧:日常生活中类似刷脸支付(大家知道智能手机、支付宝等都已支持人脸登陆)、刷脸过检等操作,岂不是存在着安全风险么?

虽然说,为了避免技术被滥用,一般研究人员不会选择公开反人脸识别系统的详细算法和原理,也不会轻易把反人脸识别技术商业化。但现实是,随着科技的发展,许多掌握高科技并且已尝到甜头的公司的做法,明显优先考虑的是利益增长,而不是道德担忧或其产品的负面影响。

不过,从谷歌内部宣布不再为五角大楼AI项目(Project Maven)续签合同一事中,大家或许也能看到,AI应用的伦理问题是不能枉顾的。

本文由venturebeat刊发,属VRPinea原创编译稿件,转载请洽:brand@vrpinea.com

评论